X4L - wzmacniacz z DSP z serii X

Biznes „nagłośnieniowy” – w porównaniu z innymi dziedzinami techniki (np. przemysłem samochodowym, czy ...

Optymalizacja systemu nagłośnieniowego – hasło brzmiące nieco tajemniczo, być może również dla części osób, które od dawna i niemal „na co dzień” przygotowują swój system do pracy, wykonując szereg czynności, określając je jako: korekcja systemu, strojenie czy w jakiś jeszcze inny potoczny, wymyślony przez siebie sposób...

Czym zatem jest owa optymalizacja systemu – tu dodam, że każdego, bo nie tylko systemu nagłośnieniowego, ale dosłownie każdego systemu złożonego z wielu współpracujących ze sobą elementów? Mówiąc w bardziej przyswajalny dla każdego śmiertelnika sposób, optymalizacja jest zespołem różnych operacji, wykonywanych w celu zwiększenia wydajności danego systemu oraz polepszenia integracji wszystkich jego składowych podsystemów tak, by uzyskany efekt końcowy, spełniał (lub może nawet przewyższał) założenia i oczekiwania sprecyzowane przez operatora. Kluczowe znaczenie ma w tej definicji określenie „złożony system” i już wyjaśniam dlaczego. Otóż pewne czynności, takie jak zestawienie elementów, przygotowanie ich do działania, dostosowanie do warunków, w jakich mają pracować, z jednoczesnym uwzględnieniem maksymalnego wykorzystania prezentowanych przez dany system możliwości, to działania znane odkąd zaczęto korzystać z systemów nagłośnieniowych. To co dziś określane jest mianem „optymalizacji”, wykonywane było zawsze, a jedyna różnica polega na tym, że zakres wykonywanych dziś operacji jest nieporównywalnie szerszy, niż dawniej, co wynika z faktu, że i współcześnie stosowane system są bardziej rozbudowane oraz zaawansowane technicznie.

Podstawą pracy nad systemem SIM była idea uzyskania wyrównanego brzmienia w całym nagłaśnianym obszarze oraz zaprojektowania odpowiedniego narzędzia, które pozwoliłoby na zrealizowanie tego założenia.

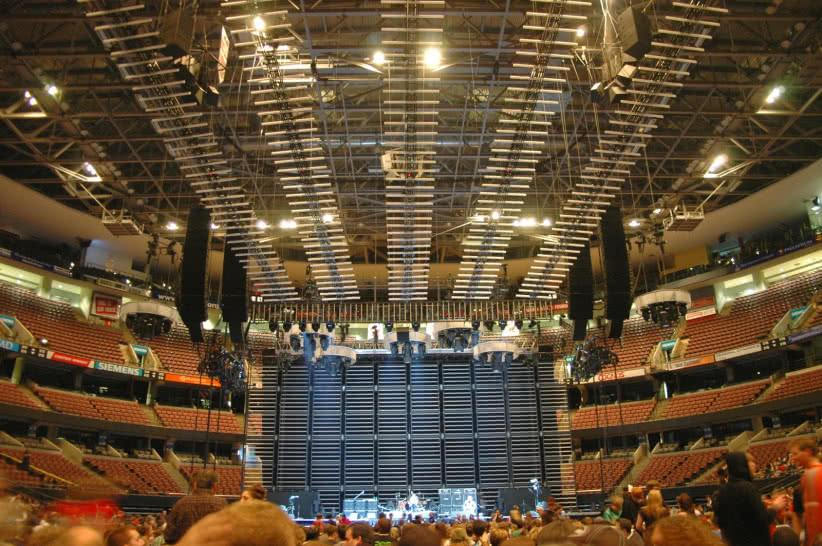

Kiedy mamy do dyspozycji dwa pasywne zestawy głośnikowe na statywach, dwukanałowy wzmacniacz i maleńką, analogową „konsoletkę”, niewiele jest elementów wymagających dopasowania zasad współpracy pomiędzy nimi, a i możliwości dostosowania tego mini-systemu do warunków pomieszczenia mieszczącego – przykładowo – 500 osób są mocno ograniczone. Znacznie szerszego zakresu operacji będzie wymagał (w tym samym pomieszczeniu) podwieszony line array, wspomagany przez zestaw subwooferów oraz frontfill, a w dodatku obsługiwany przez cyfrową konsoletę. Dawno, dawno temu – nie przypadkowo używam tu zwrotu, jakim zaczyna się wiele bajek, bo dla wielu osób należących do młodej generacji dźwiękowców, to co powiem za chwilę może być odebrane jak jakiś upiorny epizod, wyjęty z baśni braci Grimm. Jednak weterani, którzy tworzyli zręby dzisiejszej branży nagłośnieniowej, nie tylko w kraju – bo podobnie było również w Stanach i Zachodniej Europie – doskonale wiedzą, że nie są to żadne zmyślone opowiastki, ale realia pracy sprzed kilkudziesięciu lat. Kontynuując rozpoczęty wątek, cofnę się więc w dawne czasy, gdzieś tak do końcówki lat 70., w których strojenie systemu nagłośnieniowego sprowadzało się do zaledwie dwóch prostych czynności.

Pierwszą z nich było odtwarzanie dobrze znanego realizatorowi utworu (lub kilku) z... magnetofonu kasetowego. Powiało grozą? Oczywiście! W odniesieniu do dzisiejszych standardów jakości magnetofon kasetowy to żaden wiarygodny instrument referencyjny. Taśma z tworzywa sztucznego z czasem rozciągała się, a pokrywający ją materiał ferromagnetyczny zużywał pod wpływem tarcia o głowicę oraz warunków atmosferycznych. Dochodzi tu jeszcze ustawienie samej głowicy, no i rzecz jasna jakość nagrań, która także bywała bardzo różna. Wszystko to miało oczywiście wpływ na prowadzone tą metodą „testy”, a mimo to, przez wiele lat, podczas każdego koncertu – od występów początkujących wykonawców poczynając, na koncertach ówczesnych megagwiazd kończąc – magnetofon kasetowy był obowiązkowym wyposażeniem każdego stanowiska realizacyjnego. Był to powszechnie przyjęty i praktykowany standard, gdyż… innych możliwości przygotowania systemu wówczas nie było. Podczas odtwarzania nagrań, realizator wprowadzał wstępne poprawki manipulując suwakami korektora graficznego, po czym przechodził do drugiego etapu. Tym razem, posługując się – o ile mnie pamięć nie zawodzi – mikrofonem dynamicznym marki Shure, model 545 sprawdzał, czy przetwarzany przez system głos, choć trochę przypomina brzmienie jego własnego głosu, a jeśli nie przypominał, to ponownie, za pomocą korektora graficznego, starał się doprowadzić do uzyskania zadowalającego efektu. Opisana procedura polegała najczęściej na szukaniu kompromisu pomiędzy odtwarzanymi nagraniami i wypowiadanymi przez mikrofon słowami „test”, odliczaniem lub innymi – niekiedy nieartykułowanymi dźwiękami – wydalanymi z siebie za pomocą narządu mowy. Każdy szanujący się realizator miał w swojej „bibliotece” odpowiedni zestaw takich ulubionych „sygnałów testowych”, po które zawsze sięgał podczas przygotowania systemu do pracy.

W okresie gdy muzyka rockowa była u szczytu swojej popularności, wycyzelowany dźwięk nie był najważniejszą rzeczą dla większości realizatorów, bo wówczas liczyły się przede wszystkim miażdżące kilowaty!

Czy opisany powyżej sposób umożliwiał optymalne przygotowanie systemu do pracy? Nie! Czy zatem spełniał oczekiwania realizatora? Tak – przede wszystkim dlatego, że musiał, bo jak wspomniałem już wcześniej, była to w tamtym okresie powszechnie przyjęta i zarazem jedyna znana metoda. Oczekiwania realizatorów nie były zresztą zbyt wygórowane, co w znacznym stopniu wynikało ze świadomości, że możliwości ich spełnienia są mocno ograniczone technicznie. Warto w tym miejscu powiedzieć, że w latach 70., jedynymi elementami regulacyjnymi systemu PA były poziomy sygnału wysyłanego z crossovera dla poszczególnych zakresów podzielonego pasma, no i wspomniany wcześniej korektor graficzny na stanowisku realizacyjnym – przez długi czas tylko jeden na sumie głównej L/R, globalnie dla całego systemu. Początek lat 80. przyniósł pewien postęp, zwiększający możliwości operacyjne o analizę odpowiedzi systemu w czasie rzeczywistym. Dzięki pojawieniu się na rynku analizatorów RTA, opisana wcześniej procedura przygotowania systemu do pracy została rozszerzona o jeszcze jeden, trzeci etap czynności. Od tej pory, pierwszym etapem przygotowania systemu stało się wprowadzanie korekty „na oko”. Realizator śledząc odczyt wyświetlany w oknie RTA – tak jak poprzednio – manipulował suwakami korektora graficznego na stanowisku realizacyjnym. Etap drugi polegał na ocenie działania systemu „na ucho”, sprowadzając się tak samo jak wcześniej, do odsłuchania nagrań – wciąż odtwarzanych z magnetofonu kasetowego. Trzeci etap nie zmienił się wcale. Nadal polegał on na „przeliczaniu” systemu, natomiast zmienił się wykorzystywany do tego celu mikrofon. Wspomnianego wcześniej Shure 545, zastąpił nowy model, SM58, który od momentu wprowadzenia go na rynek nie tylko stał się powszechnie uznanym standardem mikrofonu wokalowego, ale też niemal natychmiast zyskał sobie opinię uniwersalnego mikrofonu o szerokich możliwościach wykorzystania.

Taaak… od tamtego okresu przebyliśmy bardzo długą drogę! Do dziś wciąż praktykowane jest „przeliczanie” systemu, ale ten moment poprzedzony jest już zawsze szeregiem innych, niezbędnych do wykonania czynności – o wiele bardziej zaawansowanych, niż tylko manipulowanie suwakami EQ, co na przestrzeni dekad wszyscy tak bardzo zdążyli polubić. Z biegiem lat systemy nagłośnieniowe rosły i ewoluowały, a wraz z tym procesem rosła też liczba czynności koniecznych do wykonania w celu właściwego przygotowania systemu do pracy, stając się operacją coraz bardziej złożoną i, jak napisałem wcześniej, dalece wykraczającą poza manipulowanie suwakami jednego tylko korektora graficznego. Teraz należało zweryfikować system, potwierdzić prawidłowość połączeń, sprawdzić polaryzację sygnałów, skompensować rozbieżności fazowe pomiędzy różnymi modelami komponentów i zoptymalizować podziały dla sekcji głośników przetwarzających poszczególne zakresy pasma. Dochodziło do tego jeszcze określenie maksymalnego, możliwego do uzyskania poziomu oraz podstawy szumu, by następnie móc zoptymalizować strukturę wzmocnienia, pozwalającą na uzyskanie maksymalnej dynamiki. Niekiedy należało również zidentyfikować źródła kompresji i zniekształceń w torze sygnału – o ile takowe się pojawiały, ale to jeszcze nie koniec przygotowań. Kiedy etap weryfikacji został ukończony, do wykonania pozostała następna grupa czynności takich jak: skorygowanie ukierunkowania głośników oraz kątów rozchylenia pomiędzy obudowami, rozmieszczenie podsystemów, dostosowanie opóźnienia, relatywnych poziomów i korekcji, a w późniejszym okresie, gdy w systemach zaczęły pojawiać się urządzenia cyfrowe połączone w sieć, doszły jeszcze kolejne czynności w postaci kompensacji i monitorowania zakresu latencji w torze sygnału.

Pojawienie się pierwszych analizatorów zapoczątkowało zacięty spór na temat wyższości ucha nad przyrządem (lub odwrotnie), który trwa do dziś, bo właściwie nie został nigdy ostatecznie rozstrzygnięty.

Oj, dużo się tego nazbierało…! Już w tym momencie, dla każdego staje się chyba jasne, że różne ograniczenia typowe dla działania analizatorów RTA, bo wynikające z ich specyfiki, uniemożliwiały przeprowadzenie wszystkich operacji koniecznych dla przygotowania nowoczesnego systemu do pracy. Wspomniane ograniczenia, jakkolwiek nie od razu przyczyniły się do rezygnacji z używania analizatorów, to jednak powodowały, że z czasem stawały się one coraz mniej znaczącym narzędziem. Przez wiele lat ich niewątpliwą zaletą była stosunkowo przystępna cena oraz to, że były poręczne i proste w obsłudze. RTA były prostym, funkcjonalnym narzędziem – jest to wielokrotnie potwierdzony fakt – ale... musimy tu brać pod uwagę również inny fakt, że czasy w których urządzenia te powstały i były powszechnie stosowane, były pod wieloma względami również o wiele prostsze. W przypadku systemów rozbudowanych o boczne „słupki” kolumn głośnikowych, czyli jak dziś mówimy „outfill”, przez długi czas nie analizowano tego, co dzieje się w obszarze ich działania. Nie analizowano, bo i po co, skoro przez długi czas korektor graficzny dostępny był wyłącznie dla sumy głównej systemu, a boczne zestawy można było jedynie podgłośnić lub przyciszyć z poziomu wzmacniaczy. Proces przygotowania systemu, określony mianem „strojenia”, był w owych czasach nieporównywalnie mniej złożony, a RTA były jedynym dostępnym i bardzo pomocnym narzędziem. Zresztą… w latach 80., czyli w okresie ogromnej popularności muzyki rockowej – we wszystkich jej obliczach – każdy realizator gotów był do kompromisów, przymykając często oko (a raczej ucho) na niuanse dotyczące jakości dźwięku, na rzecz uzyskania jak największej ilości decybeli przed sceną.

Analizatory RTA ewoluowały na przestrzeni lat – podobnie jak ewoluowały systemy nagłośnieniowe oraz proces przygotowania ich do pracy. Prosta, dobrze znana dotychczas czynność nazywana po prostu „korekcją”, zmieniała się szybko w złożoną operację określaną mianem „optymalizacji” i pomimo faktu, że analizatory RTA przez wiele lat towarzyszyły systemom nagłośnieniowym, to jednak z czasem zmuszone były ustąpić miejsca nowoczesnym urządzeniom oferującym nieporównywalnie większe możliwości. W początkowym okresie funkcjonowania systemów nagłośnieniowych, podczas przygotowania systemu do pracy brano pod uwagę głównie jedną operację, a mianowicie korekcję i słusznie, gdyż jest ona dla systemu tym, czym jest zestaw odpowiednich przypraw w każdej szanującej się kuchni. Nowy rozdział w tej dziedzinie otworzyły analizatory FFT (Fast Fourier Transform), umożliwiające wysokiej rozdzielczości podgląd odpowiedzi częstotliwościowej i fazowej systemu. Pojawienie się w użyciu analizatorów FFT początkowo wprowadziło na stanowisku realizacyjnym trochę zamieszania oraz pytań dotyczących prowadzenia procesu korekcji, wymuszając nowe spojrzenie na zmiany zachodzące w nagłaśnianym obszarze. Realizator miał wcześniej do dyspozycji RTA, mikrofon i nagrania testowe. Początkowo nikt nie mierzył odpowiedzi systemu podczas koncertu przy wypełnionej widzami arenie i nie porównywał go z odpowiedzią systemu w pustym pomieszczeniu, a pomiary i ustawienia EQ w zasadzie dotyczyły tylko stanowiska realizacyjnego. Poza obszarem, w którym znajdowała się konsoleta, bywało już niestety różnie. Jak? No właśnie – z czasem zaczęły pojawiać się tego typu pytania i było ich coraz więcej. Niektóre były może dziecinnie naiwne, ale przecież ciekawość jest cechą naturalną, polegającą na nieświadomym pragnieniu poznania nowych rzeczy, poszukiwania, badania, a tym samym i uczenia się. Jest ona siłą napędową badań naukowych i zdobywania doświadczenia w różnych sferach życia. Między innymi z tego powodu, lata 80. były okresem niewątpliwie największych dokonań w dziedzinie realizacji wielkich koncertów oraz swego rodzaju „poligonem”, umożliwiającym gromadzenie doświadczeń. Doświadczenia te stały się motorem dla tworzenia legendarnych, ponadczasowych modeli urządzeń, o czym już kiedyś przy różnych okazjach pisałem.

Przez wiele lat, podczas każdego koncertu magnetofon kasetowy był obowiązkowym wyposażeniem każdego stanowiska realizacyjnego.

Obecność analizatorów FFT zapoczątkowała, jak wspomniałem, serię pytań, ale też umożliwiła obalenie wielu „wyssanych” z palca teorii i pozwoliła na rozwianie szeregu wątpliwości typu: Czy odpowiedź systemu jest różna dla utworów granych w różnym stroju? Nie! Głośnikom jest to dokładnie obojętne, a mówiąc kolokwialnie, nacią od pietruszki zwisa im nawet to, czy wokalista mieści się w tonacji, czy też jest mocno obok! Czy odpowiedź systemu może być różna dla utworów spokojnych, lirycznych i tych bardzo dynamicznych? Nie – o ile system nie zaczyna zbliżać się do granicy swoich możliwości lub nie traci liniowości powodującej występowanie stanów nieustalonych. Czy podczas koncertu system generuje częstotliwości rytmu? Nie! Częstotliwości rytmu są w naszych głowach i nie zobaczymy ich na ekranie żadnego analizatora. Czy korektor graficzny jest rzeczywiście najlepszym narzędziem do strojenia systemu? Nie! Sprawdzał się dawno temu – zanim systemy nagłośnieniowe rozrosły się do postaci złożonych instalacji. Czy odpowiedź systemu w pustym pomieszczeniu i po wypełnieniu go przez publiczność jest różna? TAK!!! Jednak zmiany te nie są spójne i mają różnorodną tendencję. Jaką? Zgromadzone doświadczenia podpowiadały, że po wejściu publiczności dźwięk w pomieszczeniu zmienia się. Może nie zawsze zgodnie z teorią, że: „jak wejdą ludzie, to się jakość dźwięku polepszy”, choć życie zna i takie przypadki. Zaczęto zastanawiać się w jaki sposób zachodzą te zmiany, czy mają one charakter globalny, czy może raczej tylko lokalny – różny dla różnych obszarów i częstotliwości? Czy przykładowo wzmocnienie częstotliwości 300 Hz jest jednakowe w całym pokrywanym dźwiękiem obszarze, czy może ma ono różną skalę w poszczególnych obszarach widowni, a w niektórych obszarach być może wcale nie występuje? Odpowiedź na to pytanie stała się możliwa dopiero po zaimplementowaniu wielokanałowej metody pomiarowej, z możliwością porównania odczytów dla pustego i wypełnionego publicznością pomieszczenia. Okazało się, że zmiany częstotliwościowe mają charakter lokalny, a to oznacza, że skala zmian dotyczących tej samej częstotliwości bywa różna w różnych obszarach widowni. Rozumiem, że dziś nie jest to dla żadnego dźwiękowca objawieniem, ale wówczas, czyli do czasu możliwości przeprowadzenia opisanego pomiaru, nie było to w żaden racjonalny sposób potwierdzone.

Pionierskie lata 80. to pojawienie się, a właściwie dopiero eksperymenty z Meyerowym systemem SIM (Source Independent Measurement), który był wówczas jeszcze w bardzo prostej, prototypowej postaci. Podstawą pracy nad tym systemem była idea uzyskania wyrównanego brzmienia w całym nagłaśnianym obszarze oraz zaprojektowania odpowiedniego narzędzia, które pozwoliłoby na zrealizowanie tego założenia. Pomiary wykonywane były początkowo za pomocą jednego tylko mikrofonu przenoszonego z miejsca na miejsce, w celu dokonania analizy i korekcji poszczególnych składowych podsystemów. Kolejnym krokiem było wprowadzenie korekty globalnej dla całego systemu, a następnie, wprowadzenie kolejnych poprawek, już podczas trwania koncertu. Sam proces korekcji odbywał się w sposób doskonale znany i praktykowany już wcześniej, sprowadzający się do trzech podstawowych kroków – zidentyfikuj problem, rozwiąż go i sprawdź wynik działania. Jednak w tym przypadku, możliwość wizualizacji odpowiedzi w trzech funkcjach transferu: pomieszczenie – korekcja – skutek, była szalenie pomocnym rozwiązaniem. Pierwszy SIM prezentował możliwości dalekie od jego późniejszych wcieleń oraz od możliwości, które znane są z oprogramowania oferowanego na przykład przez Rational Acoustics. Jednak był on wówczas już na tyle skutecznym narzędziem, że pozwalał na optymalizację brzmienia w całym nagłaśnianym obszarze. Niestety, jak już wcześniej wspomniałem, możliwość optymalizacji nie spotkała się od razu z entuzjastycznym przyjęciem. W okresie gdy muzyka rockowa była u szczytu swojej popularności, wycyzelowany dźwięk nie był najważniejszą rzeczą dla większości realizatorów, bo wówczas liczyły się przede wszystkim miażdżące kilowaty! Optymalizacja systemu niosła co prawda obietnicę ujednolicenia dźwięku w całym nagłaśnianym obszarze, ale realizatorzy obawiali się, że może to spowodować zmniejszenie głośności w obszarze, gdzie usytuowane było stanowisko FOH. Kto w tamtych czasach mógł być zainteresowany tego rodzaju kompromisem? Żadnemu z realizatorów nie było to wówczas na rękę!

Pionierskie lata 80. to pojawienie się, a właściwie dopiero eksperymenty z Meyerowym systemem SIM (Source Independent Measurement), który był wówczas jeszcze w bardzo prostej, prototypowej postaci.

Inne spojrzenie na istotę optymalizacji systemów nagłośnieniowych przyniosły (jeszcze w latach 80.) koncerty wielkich gwiazd sceny operowej, takich jak na przykład Luciano Pavarotti oraz organizowane w latach 90. słynne koncerty „Trzech tenorów” – Plácido Domingo, José Carrerasa i Luciano Pavarottiego. Koncerty te odbywały się najczęściej w wielkich arenach lub malowniczych plenerach, a do ich realizacji wykorzystywano rozbudowane systemy nagłośnieniowe, bardzo często marki Meyer Sound. Wydarzenia te ściągały wielotysięczne tłumy miłośników opery oraz talentu mistrzów, a była to zupełnie inna kategoria publiczności, składająca się z osób wyrobionych muzycznie o ukształtowanych gustach i muzycznie wrażliwym uchu, wysoko stawiająca poprzeczkę wymagań dotyczących jakości dźwięku. Zaspokojenie oczekiwań tych słuchaczy było szalenie trudnym do zrealizowania wyzwaniem. Tego rodzaju publiczność nie ekscytowała się przytłaczającą liczbą kilowatów. Przeciwnie, oczekiwała zrównoważonego, nie „agresywnego” poziomu dźwięku, ale przede wszystkim jakości, która nie mogła być tylko „względnie dobra” albo „wystarczająco dobra”. Musiała być najwyższej jakości. Opracowane metody i odpowiedniego narzędzia pomocnego przy optymalizacji systemów nagłośnieniowych, były w tej sytuacji po prostu bezcenne! Pojawienie się pierwszych analizatorów zapoczątkowało także zacięty spór na temat wyższości ucha nad przyrządem (lub odwrotnie), który trwa do dziś, bo właściwie nie został nigdy ostatecznie rozstrzygnięty. Przypomina on trochę zabawę w przeciąganie liny – zwłaszcza, że każda z teorii, raz po raz zyskuje sobie grono nowych, zdeklarowanych zwolenników. Jednak obecnie, w czasach, gdy powszechnie używane są programy modelujące, pozwalające projektować wirtualnie systemy z możliwością symulacji pokrycia oraz wyznaczania wielu różnych parametrów, dyskusja na temat „ucho czy urządzenie” zeszła na bardzo daleki plan i nie zdarza się już aż tak często, a jeśli nawet czasem powraca, to z pewnością nie rozgrzewa już emocji tak bardzo, jak miało to miejsce przed laty.